Согласно внутренним анализам Wikipedia, вплоть до ~10% случаев текст, опубликованный в википедии, содержит элементы, которые могут быть получены с помощью искусственного интеллекта — от стилистических особенностей до логических структур, характерных для автоматически сгенерированных текстов.

Это обнаружение стало критически важным, поскольку википедия, как открытая и многопользовательская база знаний, требует высокой степени достоверности и прозрачности источников. Если даже часть текста не была написана человеком, это подрывает доверие к системе и её способности обеспечивать объективность.

Причины появления AI-содержимого в википедии

Одной из причин является автоматизация процесса редактирования. Системы, способные быстро обрабатывать и вставлять информацию, используются для ускорения ввода данных, особенно в таких областях, как технические специальности или базовые сведения о продуктах.

Другой фактор — отсутствие строгих проверок на качество и оригинальность текста. При высокой нагрузке на редакторов и ограниченном времени на ревизию, некоторые редакторы могут использовать генеративные модели для создания первоначальных версий статей, которые затем корректируются.

Проверка на искусственность

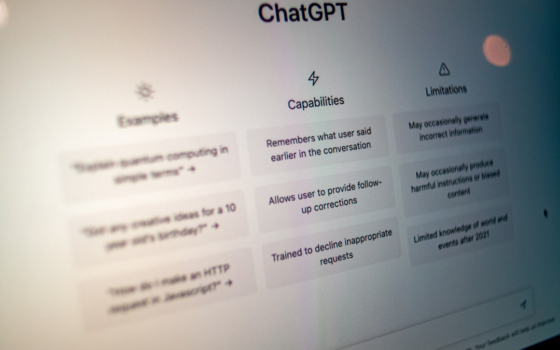

Существуют определённые признаки, позволяющие выявить, возможно, что текст был сгенерирован ИИ. Это — повторяющиеся структуры предложений, отсутствие личных наблюдений, неестественные переходы между абзацами, а также использование общих формулировок, не привязанных к конкретным примерам.

На практике аналитики применяют модели машинного обучения для выявления статистических паттернов, характерных для ИИ-генерации. Эти модели могут обнаруживать неестественные распределения слов, синтаксические конструкции и логические связи, которые не соответствуют естественному человеческому мышлению.

Если значительная часть текста в википедии является продуктом ИИ, это создаёт серьёзные риски. Во-первых, появляется вероятность введения ошибок, не обнаруженных человеком, поскольку ИИ может ошибаться в деталях, не имеющих прямого контекста. Во-вторых, снижается уровень авторского контроля — каждый текст теряет уникальность и личный отпечаток.

Это может повлиять на доверие к википедии как к источнику знаний. Пользователи могут начать сомневаться в достоверности информации, особенно если в статьях присутствуют фразы, которые звучат как «обобщённые» или «неподтверждённые».

Несмотря на то, что ИИ может ускорять процесс создания контента, его использование в открытых базах знаний создаёт серьёзные этические и функциональные проблемы. Основная цель википедии — обеспечить достоверность, объективность и прозрачность информации. Любое отклонение от этих принципов, даже в небольших масштабах, может подорвать её репутацию.

Автоматическое генерирование текста с использованием ИИ в таких системах, как википедия, требует строгого регулирования. Необходимы механизмы проверки, включая валидацию текста, анализ на признаки ИИ-содержимого и обязательную проверку на точность и оригинальность. Без таких мер википедия рискует потерять доверие как надёжный источник знаний.